執筆者:川野孝誠(@_takamasaaaaa_)

「それでも地球は回っている」という言葉で知られるガリレオ・ガリレイは、科学的手法に基づいて真実を追求した人物として、歴史にその名を刻みました。天体観測や物理学の分野での功績はもちろん、彼の最大の功績は「見えないものを見えるようにする」ための新しい視点と手段を提示したことにあります。ガリレオは、望遠鏡という当時では革新的なツールを使って天体の動きを観測し、人々が抱いていた固定観念を覆しました。

現代において、AIやLLMが日々進化を遂げている中でその内部の処理フローやアーキテクチャはどんどん複雑性を増し、「ブラックボックス問題」のような可視性に対する懸念も取り上げられています。「見えないものを見えるようにする」、つまり裏側を支えるLLMのパフォーマンスや動作、プログラムの処理フローを可視化するという流れが注目されています。

今回は、まさに上述したLLMのパフォーマンスを可視化、測定、評価することができるプラットフォームを提供しているスタートアップ・Galileoを紹介します。

「生成AI起業のヒント」では、ANOBAKAが注目している海外の生成AIスタートアップを取り上げて、生成AIの活用方法を分析・解説していきます。

生成AI領域で起業を考えられている方にとって事業のヒントとなれば幸いです。

#1 Galileoの事業内容

昨今、生成AIを活用したアプリケーションを開発するプレーヤーは増加傾向にあります。OpenAIによるGPT-4oを筆頭に、高品質なLLMをAPIで接続するだけで利用することができるため、比較的容易にプロダクトへ生成AIを実装することができているというのが背景としてあります。その一方で、市場に投入される生成AIアプリケーションが増えるに連れて、動かしている裏側のモデルに対する信頼性や正確性、安全性を確保することも同時に強く求められるようになっています。

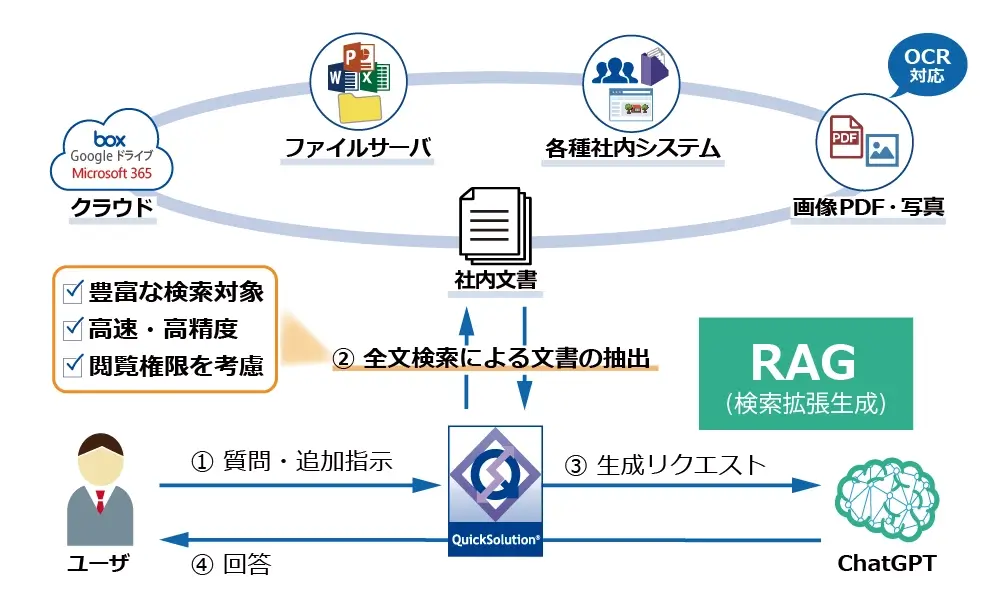

企業にとって、AI、特にLLMを導入する際の最大のリスクの1つは、ハルシネーションのようにモデルが不正確な情報や古い情報に基づいた出力をしてしまうことです。例として医療業界や金融業界はイメージしやすいかと思いますが、こうした業界では1つ1つの意思決定が人命・経済に直結するため、不正確な情報は場合によって取り返しのつかない事態を招く可能性があります。しかし、この「モデルの出力精度を高水準で担保する」ことに対しては、RAGやファインチューニングなどの解決策はあるものの、クリティカルな解決方法は確立していないのが現状であると考えています(推論というAIの特性上、ハルシネーションをゼロにすることは非現実的なのかもしれませんが)。

この問題に対して真正面から取り組んでいるのがGalileoという、生成AIアプリケーションの開発を行う企業、ないしは内部の開発者向けにモデルの評価や監視を行うツール群を提供しているスタートアップです。生成AIアプリケーションの開発から運用に至るまでの全プロセスをサポートしており、ユーザーはGalileoのツールを利用することでアプリケーションの裏側で動くLLMの正確性や信頼性、安全性を高めることができます。

下図を見ていただくとサービスの全体像を掴みやすいかと思います。

まずGalileo GenAI Studioという統合プラットフォームが全体の箱としてあり、下記の3つのモジュールで箱は構成されています。

- 迅速なテストとデバッグを可能にするモジュールであるGalileo Evaluate

- 本番環境での生成AIアプリケーションの監視をサポートするモジュールであるGalileo Observe

- プロンプトや出力の監視・制御によりユーザーを保護するモジュールであるGalileo Protect

各モジュールの説明と画像を見ていただければわかるかと思いますが、Galileo Evaluateが開発フェーズ向け、Galileo ObserveとGalileo Protectは運用フェーズ向けのモジュールとなっています。

そして画像下部に書いてあるGalileo LunaというのはGalileo独自の評価基盤モデル(Evaluation Foundation Model)なのですが、こちらの基盤モデルが事業のコアとなっており、各モジュールの裏側でLLMの出力制度や安全性を評価するために動いています。特に、ハルシネーションの検出においては既成モデルを大きく上回るパフォーマンスを出しており、企業が安心して生成AIアプリケーションを構築できる環境をサポートしています。

もう少しだけこの評価基盤モデルについて説明を加えておくと、Galileo Lunaは既成モデルと比べて低レイテンシー(遅延)、低コスト、高精度でLLMの評価を行うことができるというのが利点になっています。最近でこそ、GPT-4のようなLLMを用いてLLMを評価することが一般的な手法になってきてはいますが、従来のモデル出力を評価する方法としては人の手に頼った主観的なやり方が主流でした。

人力での作業がこれまでLLMで代替されてこなかった理由としては、正解となるデータセットを十分に用意できていないことにあると考えます。画像認識による異物検知や、生成AIを活用したEC上のフェイク品検出といった技術と同じことですが、LLMによってLLMのパフォーマンスを評価するためには、「何を正解として何を不正解とするのか」という正解の定義付けを行ったデータを学習させてやる必要があります。

しかし、現状では「何を正解とするのか」というモデルのパフォーマンスを測定・評価するための標準的な枠組みというのが存在していません。ですので、結局「このユースケースの場合はこういう出力をするのが正解である」というN=1の答えを地道に教え込んでいくしかなく、LLMを出動させるほどのスケールで正解データを用意できていなかった、だから人力に頼るしかなかったと整理することができます。

近年では、LLMによるLLMの評価に関して数多くの研究が発表されており、おかげさまで前述した通り、LLMによってLLMのパフォーマンスを評価するという手法が築き上げられつつあります。そうした流れの中にGalileoも位置しており、Galileoは1年間を費やして研究開発を行い「Guardrail Metrics」という独自のLLMのパフォーマンス評価指標を確立しました。

こちらからGalileoの発表した研究論文を読むことができます。

#2 実際にどのような場面で使われているのか

事業を概観できたところで、実際のユースケースをいくつか紹介します。

#2.1 カスタマーエンゲージメントプラットフォームの例

1つ目のユースケースは、エンタープライズ向けに既存顧客への提供サービスの品質維持と新機能の迅速な追加の両立をサポートした例です。

この会社は、世界中で5万以上の企業と200万人の開発者にパーソナライズされた顧客体験を実現するカスタマーエンゲージメントプラットフォームを提供しています。

生成AIを活用することで、会社内部のオペレーションと顧客向けソリューションの両方を革新することができると考えましたが、信頼性に定評のあるB2B2Cプラットフォームとして、市場が求めるスピードで革新を進めながらも、その信頼性を維持することができるかという壁に直面し、最後の一歩を踏み出せずにいました。

これらの競合する優先事項のバランスを取るためには、システムの出力がどのように生成されるのかを包括的に可視化し、解釈可能にする必要があります。実際、この課題が原因で、クライアント向けの次世代パーソナライゼーションを組み込んだ新機能のローンチ計画が遅れているという実害が発生していました。

この会社のAIチームは、LLMアプリケーションのパフォーマンスを処理プロセス全体にわたって可視化するためにGalileo EvaluateとGalileo Observeの2つのモジュールを導入しました。これにより、LLMの出力プロセスが完全に透明化されると共に24時間体制でパフォーマンスを監視することができ、問題が発生した際には迅速なデバッグや問題対応が可能になりました。

まとめると、この事例はGalileoをLLMアプリケーションにおける可観測性と評価の基盤として活用することで、エンタープライズレベルの信頼性を維持しながらも提供サービスのイノベーションを加速させることができた、というのがポイントです。先述した通り、計画に遅れが生じていた新機能のローンチもわずか数週間で行うことができたとのことです。

#2.2 消費財メーカー

2つ目のユースケースは、カスタマーエンゲージメントの向上に役立てた例です。

この会社は、Fortune 50企業として一般消費者向けの製品を製造しています。生成AIは既に導入済みで、顧客との会話をコントロールし、問題の核心を把握するための具体的な質問を生成する独自のチャットボットアドバイザーを運用していました。

より複雑な顧客対応を可能にするために、チャットボットからどのような質問を投げかけるのが良いのかテストを重ねていたのですが、その際に発生したログはJupyter Notebooksやドキュメント、テキストを使用して記録していました。そして、ログを1つずつ確認し、チャットボットの出力にハルシネーションが含まれていないかどうかを評価していたのですが、この作業は全て手動で行われていたために多大な時間を費やさなければなりませんでした。しかし、プロンプトやシステムが複雑化するにつれて、単純なRAGでは対応しきれなくなった上に、教師あり学習では既知の情報しか特定できないという限界が生じました。

よりスケーラブルな方法でテストを行なっていくために、この会社はGalileo EvaluateとGalileo Observeの2つのモジュールを導入しました。

その結果、プロンプトおよび出力評価にかかる時間を数週間から数日へと大幅に短縮することができました。それだけでなく、テストから得た結果と洞察は、生成AI部門が経営陣や主要な事業部門に対し、データに基づいた提案を行うことも可能にしました。また、顧客数は結果的に1年間で7〜8倍も増加しており、単なる社内ワークフローの業務効率化という話だけではなく、当初の狙い通り、複雑性の高い顧客対応も可能になったために、この会社に対する顧客のエンゲージメントを高めることができたということもわかるかと思います。

#3 LLMをLLMで評価する

#3.1 LLMの評価が今、注目されている背景

なぜ最近LLMのパフォーマンスを評価する技術がスタートアップからも、投資家からもホットテーマとして注目を集めているのか、改めて整理しておこうと思います。端的に述べると、技術の進化・普及が利用者たちの課題の解像度を高め、新たな問題の認識を促進しているという構造があるからだと整理しています。

ChatGPTが登場した直後は、LINEのようなごくシンプルなチャットというUIだけで、文章の要約や翻訳、情報収集、壁打ち相談までこんなにも新しい体験ができるのかと多くの人が驚き、生成AIという技術に対する可能性に胸を躍らせていたかと思います。しかし、生成AIを「使う・使いこなす」人が増えてきて社会への浸透が進んでいくと、実際の利用シーンにおける具体的な課題が顕在化し始めます(新たな課題として認識されるようになります)。その最たる例がハルシネーションでしょう。

新たに浮かび上がってきた課題に対処するため、これまでにもいくつかの方法が開発されてきました。ハルシネーションに関しては、出力確率を調整することでモデルの確信度を制御する方法や、ファクトチェックモデルを導入して生成内容を検証する手法、さらには外部知識を組み合わせるRAG(Retrieval-Augmented Generation;検索拡張生成)のようなアプローチが導入されています。

こうした技術の進化に伴って利用者の課題への解像度がさらに高まります。特にビジネスの現場においては、ハルシネーションを抑制したり、意図しない出力が生成されないようにコントロールしたりするというフェーズを超え、その一歩先として「実際にどれだけビジネスに対して寄与しているのか」という効果測定に対する需要が生まれてきているというのが、海外の事例を見ていても現在地であると考えています。

やや端折った説明になってしまったかもしれませんが、上記のような流れを辿っているために生成AIの裏側であるLLMの挙動を可視化し、評価することができる技術が今注目を浴びています。

#3.2 LLMの出力に対する評価方法

LLMの評価とここまで述べてきましたが、ここで「LLMの評価」と「LLMシステムの評価」は似て非なるものだという話を挟んでおきます。前者は、文字通りGPT-4oのような特定のモデルそのものの性能を測定する一方で、後者はLLM本体だけでなく、例えばエージェントとして機能するために必要な外部ツールの呼び出しや、RAGで使用される検索システムなどを含む全体的な仕組みがどのように機能するかを測定します。

よくモデルのパフォーマンス同士を比較して「◯%上回っている」などと言っているのを目にしたことがあるかと思いますが、それは、前者のモデルそのものの性能の測定・比較を指しています。本記事で使用している「LLMの評価」というのは、LLMシステム全体としてどのように機能しているかを測定・評価することを意味すると思ってください。

さて、ここからLLMシステムの評価方法という話になりますが、現在は統計的スコアに基づく評価と、モデルベースのスコアに基づく評価の2種類の方法が考案されています(ただし、下記のイラストからも分かるように両方の特性を併せ持つものもあって、明確に二分できるわけではないです)。

個別の詳細な説明は割愛しますが、左側の統計的スコアに基づく評価方法では文脈や意味を考慮することができなかったり、単純な表面的一致に依存(同義語や構文の柔軟性に対応できない)していたりするために、LLMの出力を評価する手法としては不十分です。

そこで近年、右上の緑色でグルーピングされている「LLMによってLLMを評価する(LLM-as-a-Judge)」手法が注目を集めています。

#3.3 LLM-as-a-Judge

LLM-as-a-Judgeとは、LLMを活用してLLMの出力を評価する手法のことです。従来の人間による評価はコストが高く、時間もかかるという課題を解決する代替手段として、「Judging LLM-as-a-Judge with MT-Bench and Chatbot Arena」という論文で初めて紹介されました。

LLMも結局は類推によって確率的に回答を生成しているだけなので、ハルシネーションの懸念を完全に失くすことはできませんが、モデルのバイアスを軽減するためにファインチューニングやプロンプトエンジニアリングを行うことが可能なため、よりスケーラブルであり、現状における最適解とされています。

とはいえ、まだ発展段階の技術ですので、当然ながら解決すべき課題は存在します。

課題①:自己愛バイアス(Narcissistic Bias)

LLMは自身が生成した回答を好む(過度に高い評価を与える)傾向があります。必ずしも全てのモデルにこのバイアスは見られるというわけではなく、例えばGPT-4やClaude-v1は自分の回答を10%から25%の確率で選ぶ傾向があるものの、GPT-3.5ではその傾向を示さないという研究結果もあるようです。

いずれにせよ、LLMによる評価結果に対する信頼性を損なう大きな課題であり、アカデミックの世界ではバイアスを特定し、客観的な評価が可能なフレームワークや評価基準の考案に取り組む研究も増えてきています。

Galileoも1年かけて独自の評価メトリクスを研究開発しており、実務(ビジネス)の世界だと取り組む余地は大きそうです。

課題②:多ければ多いほど良い(More is More)

「少ないほうが豊かである(Less is More)」というと、20世紀に活躍したドイツ出身の建築家であるミース・ファン・デル・ローエが残した言葉として有名ですが、LLMは簡潔なテキストよりも冗長なテキストを好む傾向があります。

「長いテキスト=より情報量が多い」と認識してしまう傾向があることに起因しており、これはLLMが冗長なだけで内容的には優れていないテキストを出力してしまう可能性があることを示唆しています。

実務の現場においては、「長々と答える割には、全然中身がない」というネガティブな体験により、ユーザーエンゲージメントの低下に繋がる可能性もあるため、LLMによる評価方法(ロジックなど)をブラックボックスにせず、透明化させておくことが重要になります。

課題③:細かな評価スコアにおける精度不足(Not-so-Fine-Grained Evaluation Scores)

LLMを用いて出力結果(生成テキスト)を評価する際に、スコアリングの粒度(評価スケールの細かさ)が細かくなればなるほど、評価精度が低下していく傾向があります。

「正しい/正しくない」「Yes/No」のように事実の正確性を二択で判断する場合や、出力結果を1〜5の5段階で評価する場合など、大まかな判断や単純な評価基準に基づく場合には比較的精度は安定しているのですが、評価スケールが例えば「1〜100」など非常に細分化されると、LLMの内部評価基準が安定しないため、どのスコアを与えるべきかの基準が曖昧になり、結果的にスコアにばらつきが生じます。

この問題に対しては、ペアワイズ比較(Pairwise Comparison)というLLM-as-a-Judgeにおける手法の1つやプロンプトエンジニアリングなど、有効とされている手法が既に存在しています。

課題④:位置バイアス(Position Bias)

LLMを用いて上述したペアワイズ比較を行う際、単純に「出力がどちらに位置しているか(順序)」によって評価が偏る傾向があります。つまり、GPT-4のようなLLMは、2番目の出力よりも最初に生成された出力の方を一般的に好む傾向があるということです。

こちらの問題も、評価を行う際に選択肢の提示順序をランダムに変更したり、複数のペアを用いて位置バイアスの影響を相対的に評価したりするなど、有効とされている手法が既に存在しています。

最近、注目を集めているLLM-as-a-Judgeについて、現状だと最適解とされているものの上述したような課題や欠点もあるという話をしてきました。また、計算コストが大きく、時間もお金もかかる上に、LLMの仕組み上ハルシネーションを完全に無くすことは現実的ではないという課題もあるため、実際の現場では従来の統計的手法や人間による最終確認と組み合わせて利用されているケースが多いようです。

技術進化に伴って計算時間や計算コストがどれくらい低下していき、どのような技術の組み合わせがベストアンサーになっていくのか、注目していきたいです。

最後になりますが、今回は下記の記事を参考にしながら記事を書いています。より技術的な話や深掘りした話が述べられているので、詳しく知りたい方はぜひ読んでいただければと思います。

- Jeffrey Ip『LLM Evaluation Metrics: The Ultimate LLM Evaluation Guide』

- Jeffrey Ip『Leveraging LLM-as-a-Judge for Automated and Scalable Evaluation』

企業情報

- 会社名:Galileo

- 本社所在地:サンフランシスコ(アメリカ)

- 最新の調達ラウンド:Series B

- 資金調達総額:1億ドル

- 主な株主:SentinelOne, Citi Ventures, PremjiInvest, ServiceNow Ventures, Battery Ventures

- カテゴリー:開発者向けAI

- 公式ホームページ:https://www.galileo.ai/

ANOBAKAでは、日本において生成AIビジネスを模索する起業家を支援し、産業育成を実現する目的で投資実行やコミュニティの組成等を行う、生成AI特化のファンドも運用しております。

生成AI領域で起業したい、ANOBAKAメンバーと話してみたいという方はぜひお問い合わせよりご連絡ください!

お問い合わせ