執筆者:梅村涼太郎

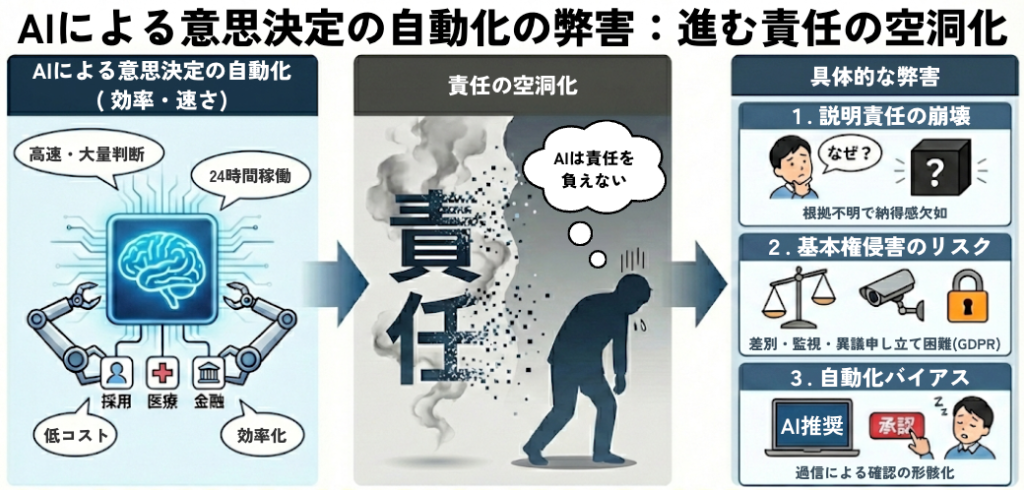

AIが急速に発展した今、AIによる人間の意思決定の代替が進んでいる。採用、経営、医療、金融など、さまざまな分野で「効率的に判断するためのAI」が現れ、導入されている。AIは人間より素早く大量の判断ができ、長時間にわたって稼働できる。一方で、決定的な問題を抱えている。AIは責任を負うことができない。

そこでフランスから生まれたのがStern Techである。意思決定の自動化がAIに代替される中で、Stern Techはあえて逆の戦略を取り、自社サービスの用途を明確に限定し、人間の意思決定支援専用としている。

これは世界初の包括的なAI法的枠組みであるEU AI Actをはじめとして、AIへの規制が進んでいるヨーロッパらしいサービスとも言える。現在の日本ではそれほどAIに対する規制は厳しくないが、今後世界中でAIへの規制が進む流れになったとき、ビジネスモデルのヒントがここにあるかもしれない。

1. 進む責任の空洞化

意思決定の自動化は、確かに効率を上げる。しかしそれと同時に、責任の所在を曖昧にする。意思決定とは本来、根拠を示し、誤りがあれば説明し、必要なら是正するところまで含む行為である。AIはその責任を負えない。結果として、自動化が進むほど責任の空洞化が進む。

まず、説明責任が崩れやすくなる。採用でも医療でも金融でも、当事者に「なぜその判断になったのか」を説明する必要がある。ところがAIには入力に対して、なぜその出力になったのか説明する能力はない。現場は「AIがそう言った」以上の言葉を持てなくなり、組織として納得を作れなくなる。

次に、基本権侵害のリスクが上がる。自動化された判断は、差別、過剰監視、プライバシー侵害、異議申立て機会の欠如を引き起こし得る。GDPR(EU一般データ保護規則)第22条は、法的効果または同様に重大な影響を与える完全自動化された意思決定について、本人がその対象とならない権利を定めている。したがって、大きな影響が生じ得る判断ほど自動化は摩擦を生みやすい。

さらに、自動化バイアスが起きる。人は機械の推奨を過信しやすく、反証探索が弱くなる。その結果、人間による確認が形骸化し、人間が監督しているはずなのに止められないという状態が生まれる。

要するに、意思決定の自動化は速さを手に入れる一方で、責任や納得とトレードオフの構造を持つのである。

2. Stern Techの事業内容

改めてStern Techとは、2022年7月に設立されたスタートアップで、認知科学とAIを掛け合わせたプロダクトをを提供している。2025年12月にはF6SのCognitive Computing companies and startupsのランキングにて10位にもなっている。

Stern Techは、この構造的な問題に対して、そもそもの設計思想を変える立場を取っている。同社はサービスを人間の意思決定支援に限定し、自動または自律的な意思決定は行わないと明示している。加えて、技術はフランスで所有・開発・ガバナンスされ、GDPRおよびEU AI Act準拠、そしてhuman oversight by design(人間の監督を前提とした設計)を掲げている。要するに、Stern Techが提供しようとしているのはAIが決める仕組みではなく、人間が責任を持って決められる新たな意思決定のプロセスなのである。

ここでStern Techの提供する4つのサービスを紹介する。

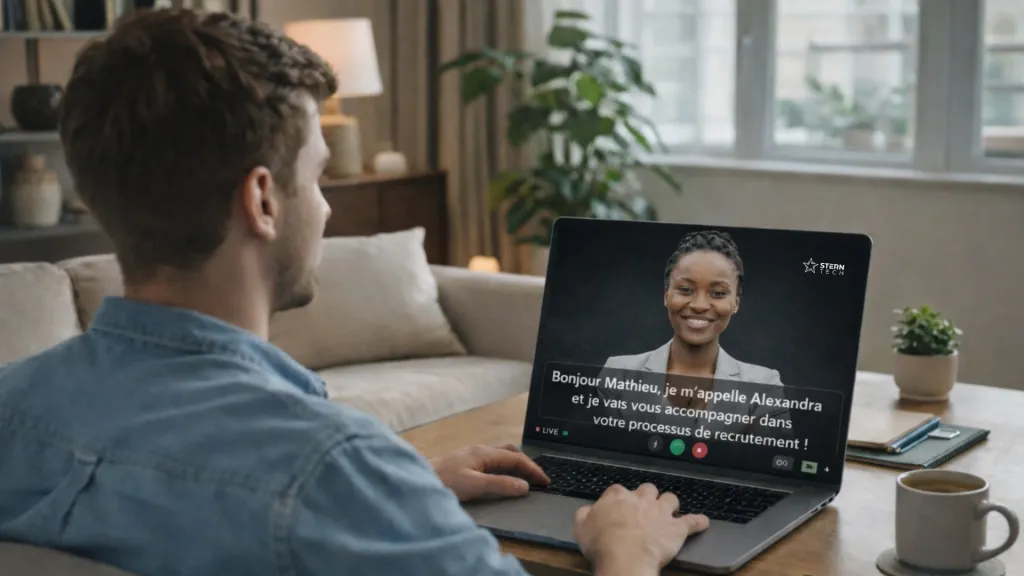

Alex(採用)

採用はEU AI Actでは人生機会に直結する高リスク領域に分類される事業である。ここで自動スコアリングが批判されやすいのは当然だ。そこでAlexは同社の自動決定しないという全体方針のもとで、評価・選考に関わる意思決定を支援するサービスを提供する。

Pegasus(市場調査・意思決定インサイト)

Pegasusは、行動データとAIモデルを用いて洞察を提示しつつ、結論を断定するのではなく、判断材料を整理して提供するサービスである。確率的推定であることや免責の記載を伴う。

Shield(ヘルスケア)

Shieldは、情緒・社会・心理的ディストレスの兆候を早期に捉え、臨床判断を補完するサービスである。医療評価を置き換えないと明記している。加えてGDPRとEU AI Act準拠を明示する。医療のように説明責任が不可避な領域で「支援」に限定する姿勢がはっきりしている。

WiseDriver(モビリティ)

WiseDriverは交通安全という高リスク領域に向け、注意・負荷・リスクの可視化などを通じて意思決定を支援するサービスである。運転者や指導者を置き換えるのではなく、危険な兆候を把握しやすくする協働の構造を作る。

例えば、Stern TechはSoftware Républiqueのコンセプトカー「H1st Vision」に対してこのWiseDriverを提供し、ドライバーの非言語的手がかりからAIが注意・感情・メンタル負荷を観測することを可能にしている。また、STMicroelectronicsと提携し、自動車の組み込みシステムに直接統合することが可能となった。現在はまだコンセプトカーや組み込みの段階だが、これから普及した際にはドライバーの表情や視線から疲労などを読み取り、休憩を進めるなど、自動車における新たなAIとの関わりが生まれるかもしれない。

これらサービスの中心となる考え方は一言で表されている。

AI must serve human decision-making, respect fundamental rights, and remain under human control.

(AIは人間の意思決定を支え、基本的人権を尊重し、そして人間による管理下に置かなければならない。)

これは単なる理念ではない。Stern Techが掲げるdecision-support only、No automated decisions、human oversight by designは、AIを用いたプロダクトを社会に実装するための枠組みそのものである。

これら意思決定支援AIを導入する企業のメリットとしては、やはり法規制への対応が挙げられる。重要な意思決定に関してはEU AI Actでは高リスク領域に分類され、AIによる完全自動な意思決定は規制される。高リスク領域ほど、導入後に求められるのは説明責任・監査可能性・異議申立て対応であり、ここが運用コストと導入難易度を押し上げる。

支援型AIは、意思決定そのものを代替しない代わりに、判断材料の整理、反証観点の提示、リスクの可視化、そして人間の介入・最終判断をログとして残すことで、監査・係争対応を簡易化できる。結果として、AI導入が止まりがちな領域でもサービスが導入・運用されやすくなり、意思決定プロセス全体の生産性を上げることができるのである。

3. 「意思決定支援」で単価を成立させる設計:ビジネスモデルとオペレーションの中身

Stern Techの示唆は、倫理を掲げること自体ではなく、「意思決定支援」という制約をプロダクト設計・運用設計・価格設計のすべてに適用し、支援でも単価が成立する形に落としている点にある。自動化AIが「人件費代替」の財布を取りに行くのに対し、支援型AIは「失敗コストの期待値」「監査・説明対応の運用コスト」「意思決定の生産性向上」をてこに、別の財布を作る。

3-1. 課金単位を意思決定数にする

Stern Techが採用・調査・医療・モビリティで共通しているのは、価格がユーザー数よりも意思決定の回数に紐づく設計である。

これは、「支援=安い」にならないための重要な工夫だ。意思決定は企業活動の中心にあり、件数が増えるほど失敗リスクや運用負荷も増える。そこに従量課金を置けば、導入初期は入りやすく、利用拡大とともに売上が自然に伸びる。支援型の勝ち筋は、AIが決めることではなく、意思決定プロセスの中で不可避に発生する作業を商品化することにある。

3-2. 実際のオペレーションはどう変わるか:AIに「判断」させるのではなく「プロセス」に組み込む

支援型AIの導入で現場が得るのは、結論の自動生成ではない。プロセス上のボトルネックを分解し、AIを部品として差し込むことだ。典型的には次の形になる。

- 入力(状況・候補・観測データ)

- AIの出力(結論ではなく、判断材料の束)

- 根拠の要約、反証観点、追加で確認すべき質問、確信度、注意すべきリスク因子

- 人間の介入(採用/却下/保留/追加調査)

- 最終決定(責任主体の固定)

- 記録(監査・説明のための証跡)

重要なのは、AI出力を最終決定として扱わないことである。AIが提供するのは判断の材料であり、最終決定の主体は常に人間に任される。この責任があるからこそ、後から説明と是正が可能になり、運用コストをコントロールできる。

3-3. 自動化バイアスは避けられない前提で仕組み化する

「支援」と言っても、自動化バイアスが自然に消えるわけではない。人は推奨を見た瞬間に思考を止めやすく、反証探索が弱くなる。支援型AIで勝つには、バイアスが起きないように祈るのではなく、起きる前提で、ワークフローにブレーキを組み込む必要がある。

Stern Tech的な「支援に徹する」ための設計論は、次の3点に集約できる。

- 出力を断定しない

「〜すべき」ではなく、リスク・可能性・不足情報・追加質問として提示する。出力の文体を含めて、決裁権限を奪わない設計にする。 - 上書き・無視・文脈化を常に可能にする

最も重要なのは、ユーザーが常に判断できる状態であることだ。そこで、AIの出力に対してそれらを自分の文脈に取り入れることはもちろん、自分なりに上書きしたり、時には無視できる設計にする。 - 意思決定の追跡を可能にする

誰が何をどう判断したのか、後から確認できるようにする。これには、例えばユーザーが介入した時点で、その結果をログとして残すことが有効である。

3-4. 支援型AIは「規制対応」ではなく「稟議が通る意思決定OS」である

支援型AIが企業にとって重宝される理由は、規制に配慮しているからだけではない。むしろ、「責任者がサインできる」「監査で説明できる」という運用要件を満たすから導入が進む。

ここでの勝ち筋は、精度競争ではなく、意思決定のプロセスを「出荷可能な形」にパッケージすることだ。支援に徹するための境界を明文化し、反証提示・人間介入・ログをプロダクトのコアに置く。この設計ができたとき、支援型AIは「単価が取れないツール」ではなく、「高リスク領域でも導入できる意思決定基盤」として価値が成立する。

4. 意思決定支援は自動化とは違う新たな意思決定プロセスである

AIによる意思決定の過信による責任の空洞化に対して、意思決定支援は設計思想が異なる。判断をAIに委譲しない。AIは結論を確定しない。あくまでAIは人間の判断を成立させるための材料を整理し、リスクを見える化し、反証の観点を提示する。最終決定は人間が行い、必要ならAIの提案を退けることもできる。ここで重要なのは、責任の主体が最初から人間に固定される点である。責任が固定されるからこそ、説明責任が設計可能になる。

この「支援としてのAI」は、EU AI Actが求める統制構造とも整合しやすい。EU AI Actでは高リスクAIに対し、人間の監督が健康・安全・基本権に関するリスクを防止・最小化することを目的として明記されている。つまり、AIが出力した結果に対して、人間が意味のある形で介入できるようにしておくことが前提となる。意思決定支援は、この前提をプロダクトの中心に置く設計である。

さらに、説明責任を現実の運用に落とし込むためには、証拠が必要となる。EU AI Actは高リスクAIについて記録保持の考え方をはっきりと求めており、システムがイベントを自動記録できることを要件として掲げている。加えて、運用側にもログ保持などの義務が整理されている。意思決定支援としてAIを設計する場合、AIの提示内容、提示時点、ユーザーの介入(採用・却下・修正)、最終決定者をログとして残す設計が取りやすい。これはそのまま監査可能性とトレーサビリティを生み、説明責任の中核になる。要するに、意思決定支援は、ログで追跡可能な意思決定プロセスを作ることで、規制が求める統制構造と、現場が求める説明責任を同時に満たすアプローチである。

Stern Techが「意思決定支援専用」「自動または自律的な意思決定は行わない」「human oversight by design」「GDPRおよびEU AI Act準拠」を前面に出しているのは、まさにこの道を選んでいるからである。支援に限定することは、速度競争ではなく、説明責任をプロダクト価値の中心に置くという意思表示である。

結論

いま問われているのは「何を自動化できるか」ではない。「何を自動化してはいけないか」である。意思決定の自動化は速いが、責任と納得を壊しやすい。だからこそ、これからのAI利用には、「AIを使ったが責任を取ることができる」という状態が求められる。

Stern Techは、その方向性を「意思決定支援に限定する」という明確な線引きで示した。この潮流は、今後さまざまな領域において標準となっていくのではないだろうか。